Best Practices for Building Chatbot Training Datasets

TyDi QA is a set of question response data covering 11 typologically diverse languages with 204K question-answer pairs. It contains linguistic phenomena that would not be found in English-only corpora. These operations require a much more complete understanding of paragraph content than was required for previous data sets.

Chatbot training datasets from multilingual dataset to dialogues and customer support chatbots. E-commerce chatbot datasets often contain sensitive customer information. Ensuring data privacy and compliance with relevant regulations, such as GDPR, is crucial to protect user data and avoid legal issues. In conclusion, chatbot training is a critical factor in the success of AI chatbots.

Based on CNN articles from the DeepMind Q&A database, we have prepared a Reading Comprehension dataset of 120,000 pairs of questions and answers. When looking for brand ambassadors, you want to ensure they reflect your brand (virtually or physically). One negative of open source data is that it won’t be tailored to your brand voice. It will help with general conversation training and improve the starting point of a chatbot’s understanding.

Conversational AI Statistics: NLP Chatbots in 2020

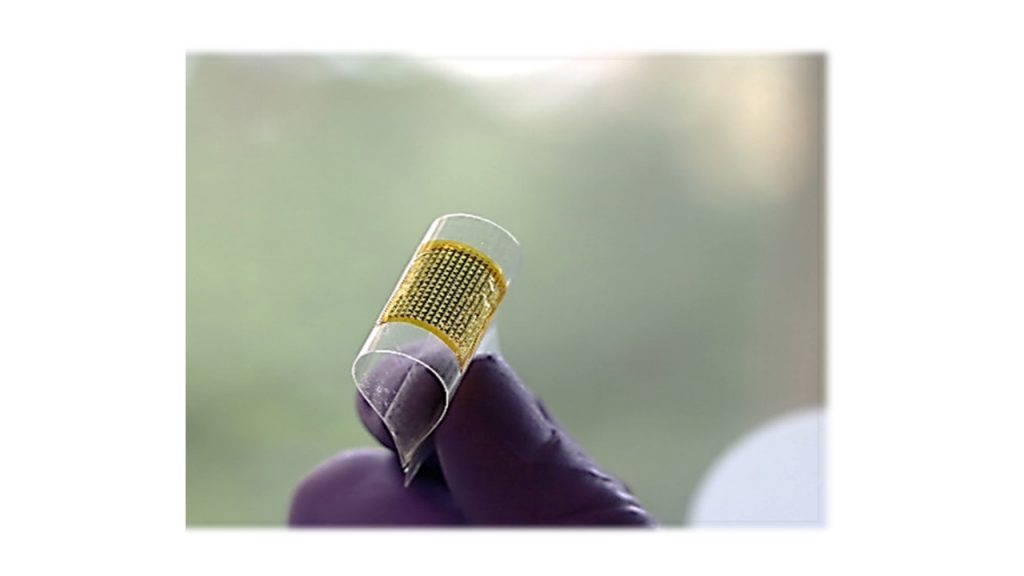

The process of chatbot training is intricate, requiring a vast and diverse chatbot training dataset to cover the myriad ways users may phrase their questions or express their needs. This diversity in the chatbot training dataset allows the AI to recognize and respond to a wide range of queries, from straightforward informational requests to complex problem-solving scenarios. Moreover, the chatbot training dataset must be regularly enriched and expanded to keep pace with changes in language, customer preferences, and business offerings. Each of the entries on this list contains relevant data including customer support data, multilingual data, dialogue data, and question-answer data. This type of training data is specifically helpful for startups, relatively new companies, small businesses, or those with a tiny customer base.

We use all the text-book questions in Chapters 1 to 5 that have solutions available on the book’s official website. ChatGPT Software Testing Study Dataset contains questions from a well-known software testing book by Ammann and Offutt. It uses all the textbook questions in Chapters 1 to 5 that have solutions available on the book’s official website. Questions that are not in the student solution are omitted because publishing our results might expose answers that the authors of the book do not intend to make public.

Testing and validation are essential steps in ensuring that your custom-trained chatbot performs optimally and meets user expectations. In this chapter, we’ll explore various testing methods and validation techniques, providing code snippets to illustrate these concepts. In the next chapters, we will delve into testing and validation to ensure your custom-trained chatbot performs optimally and deployment strategies to make it accessible to users. Intent recognition is the process of identifying the user’s intent or purpose behind a message. It’s the foundation of effective chatbot interactions because it determines how the chatbot should respond. In the OPUS project they try to convert and align free online data, to add linguistic annotation, and to provide the community with a publicly available parallel corpus.

Chapter 3: Data Collection and Preparation

You then draw a map of the conversation flow, write sample conversations, and decide what answers your chatbot should give. A data set of 502 dialogues with 12,000 annotated statements between a user and a wizard discussing natural language movie preferences. The data were collected using the Oz Assistant method between two paid workers, one of whom acts as an “assistant” and the other as a “user”. More and more customers are not only open to chatbots, they prefer chatbots as a communication channel. When you decide to build and implement chatbot tech for your business, you want to get it right. You need to give customers a natural human-like experience via a capable and effective virtual agent.

This may be the most obvious source of data, but it is also the most important. Text and transcription data from your databases will be the most relevant to your business and your target audience. The Metaphorical Connections dataset is a poetry dataset that contains annotations between metaphorical prompts and short poems.

Through meticulous chatbot training, businesses can ensure that their AI chatbots are not only efficient and safe but also truly aligned with their brand’s voice and customer service goals. As AI technology continues to advance, the importance of effective chatbot training will only grow, highlighting the need for businesses to invest in this crucial aspect of AI chatbot development. By focusing on intent recognition, entity recognition, and context handling during the training process, you can equip your chatbot to engage in meaningful and context-aware conversations with users. These capabilities are essential for delivering a superior user experience. In this chapter, we’ll explore why training a chatbot with custom datasets is crucial for delivering a personalized and effective user experience. We’ll discuss the limitations of pre-built models and the benefits of custom training.

Each poem is annotated whether or not it successfully communicates the idea of the metaphorical prompt. Log in

or

Sign Up

to review the conditions and access this dataset content. Chatbots’ fast response times benefit those who want a quick answer to something without having to wait for long periods for human assistance; that’s handy! This is especially true when you need some immediate advice or information that most people won’t take the time out for because they have so many other things to do. This includes transcriptions from telephone calls, transactions, documents, and anything else you and your team can dig up.

Designing the conversational flow for your chatbot

Chatbot training is an essential course you must take to implement an AI chatbot. In the rapidly evolving landscape of artificial intelligence, the effectiveness of AI chatbots hinges significantly on the quality and relevance of their training data. The process of “chatbot training” is not merely a technical task; it’s a strategic endeavor that shapes the way chatbots interact with users, understand queries, and provide responses. As businesses increasingly rely on AI chatbots to streamline customer service, enhance user engagement, and automate responses, the question of “Where does a chatbot get its data?” becomes paramount. E-commerce chatbot datasets are a cornerstone of efficient and customer-friendly online shopping experiences. Businesses that leverage these datasets effectively can enhance customer support, improve user satisfaction, boost efficiency, and increase sales.

User feedback is a valuable resource for understanding how well your chatbot is performing and identifying areas for improvement. Having Hadoop or Hadoop Distributed File System (HDFS) will go a long way toward streamlining the data https://chat.openai.com/ parsing process. In short, it’s less capable than a Hadoop database architecture but will give your team the easy access to chatbot data that they need. Chatbots have evolved to become one of the current trends for eCommerce.

CoQA is a large-scale data set for the construction of conversational question answering systems. The CoQA contains 127,000 questions with answers, obtained from 8,000 conversations involving text passages from seven different domains. Inaccurate or outdated information can lead to incorrect responses, frustrating customers. Regularly updating and cleaning datasets is necessary to ensure high-quality data. This aspect of chatbot training underscores the importance of a proactive approach to data management and AI training.

When non-native English speakers use your chatbot, they may write in a way that makes sense as a literal translation from their native tongue. Any human agent would autocorrect the grammar in their minds and respond appropriately. But the bot will either misunderstand and reply incorrectly or just completely be stumped.

Our dataset exceeds the size of existing task-oriented dialog corpora, while highlighting the challenges of creating large-scale virtual wizards. It provides a challenging test bed for a number of tasks, including language comprehension, slot filling, dialog status monitoring, and response generation. It consists of more than 36,000 pairs of automatically generated questions and answers from approximately 20,000 unique recipes with step-by-step instructions and images.

QASC is a question-and-answer data set that focuses on sentence composition. It consists of 9,980 8-channel multiple-choice questions on elementary school science (8,134 train, 926 dev, 920 test), and is accompanied by a corpus of 17M sentences. Doing this will help boost the relevance and effectiveness of any chatbot training process. Get a quote for an end-to-end data solution to your specific requirements. In the final chapter, we recap the importance of custom training for chatbots and highlight the key takeaways from this comprehensive guide.

A large-scale collection of visually-grounded, task-oriented dialogues in English designed to investigate shared dialogue history accumulating during conversation. We deal with all types of Data Licensing be it text, audio, video, or image. Building a chatbot with coding can be difficult for people without development experience, so it’s worth looking at sample code from experts as an entry point. OpenBookQA, inspired by open-book exams to assess human understanding of a subject. The open book that accompanies our questions is a set of 1329 elementary level scientific facts. Approximately 6,000 questions focus on understanding these facts and applying them to new situations.

Natural language understanding (NLU) is as important as any other component of the chatbot training process. Entity extraction is a necessary step to building an accurate NLU that can comprehend the meaning and cut through noisy data. There is a wealth of open-source chatbot training data available to organizations.

Start with your own databases and expand out to as much relevant information as you can gather. Maintaining and continuously improving your chatbot is essential for keeping it effective, relevant, and aligned with evolving user needs. In this chapter, we’ll delve into the importance of ongoing maintenance and provide code snippets to help you implement continuous improvement practices. However, before making any drawings, you should have an idea of the general conversation topics that will be covered in your conversations with users. This means identifying all the potential questions users might ask about your products or services and organizing them by importance.

Data scraping involves extracting information from various online sources, such as product descriptions, reviews, and customer inquiries. This data can be valuable for training chatbots to provide accurate and up-to-date information about products and services. Public datasets are openly available for research and ChatGPT development. They are an excellent resource for getting started with chatbot training.

E-commerce has witnessed a seismic shift in recent years, with a growing number of consumers opting for online shopping. With this surge in e-commerce activities, businesses are continually seeking innovative ways to provide efficient and personalized customer support. One such innovation is the integration of chatbots, AI-driven virtual assistants that can engage customers in real-time conversations. To make these chatbots effective, businesses rely on Ecommerce chatbot dataset, which are the lifeblood of AI chatbots, enabling them to understand, process, and respond to customer queries. Dialogue datasets are pre-labeled collections of dialogue that represent a variety of topics and genres. They can be used to train models for language processing tasks such as sentiment analysis, summarization, question answering, or machine translation.

At the core of any successful AI chatbot, such as Sendbird’s AI Chatbot, lies its chatbot training dataset. This dataset serves as the blueprint for the chatbot’s understanding of language, enabling it to parse user inquiries, discern intent, and deliver accurate and relevant responses. However, the question of “Is chat AI safe?” often arises, underscoring the need for secure, high-quality chatbot training datasets. Ensuring the safety and reliability of chat AI involves rigorous data selection, validation, and continuous updates to the chatbot training dataset to reflect evolving language use and customer expectations.

As chatbot technology continues to advance, ensuring the quality, privacy, and multilingual support of these datasets will be key to staying ahead in the competitive e-commerce landscape. With the right datasets and practices in place, e-commerce chatbots are poised to transform the way we shop online, providing users with personalized, real-time assistance, and a seamless purchasing journey. Customizing chatbot training to leverage a business’s unique data sets the stage for a truly effective and personalized AI chatbot experience.

How to Train Chatbot on Your Own Data: A Customized Approach

Your project development team has to identify and map out these utterances to avoid a painful deployment. The vast majority of open source chatbot data is only available in English. It will train your chatbot to comprehend and respond in fluent, native English. It can cause problems depending on where you are based and in what markets. Answering the second question means your chatbot will effectively answer concerns and resolve problems.

You can process a large amount of unstructured data in rapid time with many solutions. Implementing a Databricks Hadoop migration would be an effective way for you to leverage such large amounts of data. Finnish chat conversation corpus and includes unscripted conversations on seven topics from people of different ages. Taiga is a corpus, where text sources and their meta-information are collected according to popular ML tasks. To analyze how these capabilities would mesh together in a natural conversation, and compare the performance of different architectures and training schemes.

While open source data is a good option, it does cary a few disadvantages when compared to other data sources. When it comes to deploying your chatbot, you have several hosting options to consider. Each option has its advantages and trade-offs, depending on your project’s requirements. Obtaining appropriate data has always been an issue for many AI research companies. We provide connection between your company and qualified crowd workers. Your coding skills should help you decide whether to use a code-based or non-coding framework.

Businesses must regularly review and refine their chatbot training processes, incorporating new data, feedback from user interactions, and insights from customer service teams to enhance the chatbot’s performance continually. Natural Questions (NQ), a new large-scale corpus for training and evaluating open-ended question answering systems, and the first to replicate the end-to-end process in which people find answers to questions. NQ is a large corpus, consisting of 300,000 questions of natural origin, as well as human-annotated answers from Wikipedia pages, for use in training in quality assurance systems. In addition, we have included 16,000 examples where the answers (to the same questions) are provided by 5 different annotators, useful for evaluating the performance of the QA systems learned. HotpotQA is a set of question response data that includes natural multi-skip questions, with a strong emphasis on supporting facts to allow for more explicit question answering systems.

- Dive into model-in-the-loop, active learning, and implement automation strategies in your own projects.

- E-commerce chatbots are AI-powered virtual assistants that engage with customers in real-time through chat interfaces.

- Ensuring the safety and reliability of chat AI involves rigorous data selection, validation, and continuous updates to the chatbot training dataset to reflect evolving language use and customer expectations.

- They are also crucial for applying machine learning techniques to solve specific problems.

- Likewise, with brand voice, they won’t be tailored to the nature of your business, your products, and your customers.

Keyword-based chatbots are easier to create, but the lack of contextualization may make them appear stilted and unrealistic. Contextualized chatbots are more complex, but they can be trained to respond naturally to various inputs by using machine learning algorithms. Customer support datasets are databases that contain customer information. Customer support datasets for chatbots data is usually collected through chat or email channels and sometimes phone calls. These databases are often used to find patterns in how customers behave, so companies can improve their products and services to better serve the needs of their clients. As important, prioritize the right chatbot data to drive the machine learning and NLU process.

This aspect of chatbot training is crucial for businesses aiming to provide a customer service experience that feels personal and caring, rather than mechanical and impersonal. An effective chatbot requires a massive amount of training data in order to quickly resolve user requests without human intervention. However, the main obstacle to the development of a chatbot is obtaining realistic and task-oriented dialog data to train these machine learning-based systems. Just like students at educational institutions everywhere, chatbots need the best resources at their disposal. This chatbot data is integral as it will guide the machine learning process towards reaching your goal of an effective and conversational virtual agent. Training a chatbot on your own data not only enhances its ability to provide relevant and accurate responses but also ensures that the chatbot embodies the brand’s personality and values.

We encourage you to embark on your chatbot development journey with confidence, armed with the knowledge and skills to create a truly intelligent and effective chatbot. In the next chapter, we will explore the importance of maintenance and continuous improvement to ensure your chatbot remains effective and relevant over time. In the next chapters, we will delve into deployment strategies to make your chatbot accessible to users and the importance of maintenance and continuous improvement for long-term success. You can use a web page, mobile app, or SMS/text messaging as the user interface for your chatbot. The goal of a good user experience is simple and intuitive interfaces that are as similar to natural human conversations as possible.

This saves time and money and gives many customers access to their preferred communication channel. By proactively handling new data and monitoring user feedback, you can ensure that your chatbot remains relevant and responsive to user needs. Continuous improvement based on user input is a key factor in maintaining a successful chatbot.

No matter what datasets you use, you will want to collect as many relevant utterances as possible. These are words and phrases that work towards the same goal or intent. We don’t think about it consciously, but there are many ways to ask the same question. Customer support is an area where you will need customized training to ensure chatbot efficacy. There are two main options businesses have for collecting chatbot data. Entity recognition involves identifying specific pieces of information within a user’s message.

But the style and vocabulary representing your company will be severely lacking; it won’t have any personality or human touch. Many customers can be discouraged by rigid and robot-like experiences with a mediocre chatbot. Solving the first question will ensure your chatbot is adept and fluent at conversing with your audience. A conversational chatbot will represent your brand and give customers the experience they expect.

The datasets you use to train your chatbot will depend on the type of chatbot you intend to create. The two main ones are context-based chatbots and keyword-based chatbots. Deploying your custom-trained chatbot is a crucial step in making it accessible to users. In this chapter, we’ll explore various deployment strategies and provide code snippets to help you get your chatbot up and running in a production environment. Before you embark on training your chatbot with custom datasets, you’ll need to ensure you have the necessary prerequisites in place.

The journey of chatbot training is ongoing, reflecting the dynamic nature of language, customer expectations, and business landscapes. Continuous updates to the chatbot training dataset are essential for maintaining the relevance and effectiveness of the AI, ensuring that it can adapt to new products, services, and customer inquiries. Chatbots have revolutionized the way businesses interact with their customers. They offer 24/7 support, streamline processes, and provide personalized assistance. However, to make a chatbot truly effective and intelligent, it needs to be trained with custom datasets. In this comprehensive guide, we’ll take you through the process of training a chatbot with custom datasets, complete with detailed explanations, real-world examples, an installation guide, and code snippets.

More than 400,000 lines of potential questions duplicate question pairs. You can foun additiona information about ai customer service and artificial intelligence and NLP. When building a marketing campaign, general data may inform your early steps in ad building. But when implementing a tool like a Bing Ads dashboard, you will collect much more relevant data. Chatbot data collected from your resources will go the furthest to rapid project development and deployment. Make sure to glean data from your business tools, like a filled-out PandaDoc consulting proposal template.

Having the right kind of data is most important for tech like machine learning. And back then, “bot” was a fitting name as most human interactions with this new technology were machine-like. Dataset Description

Our dataset contains questions from a well-known software testing book Introduction to Software Testing 2nd Edition by Ammann and Offutt.

We recently updated our website with a list of the best open-sourced datasets used by ML teams across industries. We are constantly updating this page, adding more datasets to help you find the best training data you need for your projects. It’s important to have the right data, parse out entities, and group utterances. But don’t forget the customer-chatbot interaction is all about understanding intent and responding appropriately. If a customer asks about Apache Kudu documentation, they probably want to be fast-tracked to a PDF or white paper for the columnar storage solution.

To keep your chatbot up-to-date and responsive, you need to handle new data effectively. New data may include updates to products or services, changes in user preferences, or modifications to the conversational context. SGD (Schema-Guided Dialogue) dataset, containing over 16k of multi-domain conversations covering 16 domains.

This Colab notebook provides some visualizations and shows how to compute Elo ratings with the dataset. Deploying your chatbot and integrating it with messaging platforms extends its reach and allows users to access its capabilities where they are most comfortable. To reach a broader audience, you can integrate your chatbot with popular messaging platforms where your users are already active, such as Facebook Messenger, Slack, or your own website. Building a chatbot from the ground up is best left to someone who is highly tech-savvy and has a basic understanding of, if not complete mastery of, coding and how to build programs from scratch. To get started, you’ll need to decide on your chatbot-building platform. Pick a ready to use chatbot template and customise it as per your needs.

Some publicly available sources are The WikiQA Corpus, Yahoo Language Data, and Twitter Support (yes, all social media interactions have more value than you may have thought). Each has its pros and cons with how quickly learning takes place and how natural conversations will be. The good news is that you can solve the two main questions by choosing the appropriate chatbot data. E-commerce websites cater to a global audience, requiring chatbots to support multiple languages.

We have drawn up the final list of the best conversational data sets to form a chatbot, broken down into question-answer data, customer support data, dialog data, and multilingual data. While helpful and free, huge pools of chatbot training data will be generic. Likewise, with brand voice, they won’t be tailored to the nature of your business, your products, and your customers. In this chapter, we’ll explore the training process in detail, including intent recognition, entity recognition, and context handling. Context-based chatbots can produce human-like conversations with the user based on natural language inputs. On the other hand, keyword bots can only use predetermined keywords and canned responses that developers have programmed.

This is where you parse the critical entities (or variables) and tag them with identifiers. For example, let’s look at the question, “Where is the nearest ATM to my current location? “Current location” would be a reference entity, while “nearest” would be a distance entity. Building and implementing a chatbot is always a positive for any business. To avoid creating more problems than you solve, you will want to watch out for the most mistakes organizations make.

With more than 100,000 question-answer pairs on more than 500 articles, SQuAD is significantly larger than previous reading comprehension datasets. SQuAD2.0 combines the 100,000 questions from SQuAD1.1 with more than 50,000 new unanswered questions written in a contradictory manner by crowd workers to look like answered questions. The objective of the NewsQA dataset is to help the research community build algorithms capable of answering questions that require human-scale understanding and reasoning skills.

When It Comes to AI Models, Bigger Isn’t Always Better – Scientific American

When It Comes to AI Models, Bigger Isn’t Always Better.

Posted: Tue, 21 Nov 2023 08:00:00 GMT [source]

For example, in a chatbot for a pizza delivery service, recognizing the “topping” or “size” mentioned by the user is crucial for fulfilling their order accurately. Multilingual datasets are composed of texts written in different languages. Multilingually encoded corpora are a critical resource for many Natural Language Processing research projects that require large amounts of annotated text (e.g., machine translation).

E-commerce chatbots are AI-powered virtual assistants that engage with customers in real-time through chat interfaces. They provide information, answer queries, assist in product searches, and facilitate the online shopping process. These chatbots use Natural Language Processing (NLP) and machine learning algorithms to understand and respond to user queries, making them a valuable addition to e-commerce websites. The delicate balance between creating a chatbot that is both technically efficient and capable of engaging users with empathy and understanding is important. Chatbot training must extend beyond mere data processing and response generation; it must imbue the AI with a sense of human-like empathy, enabling it to respond to users’ emotions and tones appropriately.

However, they may require additional preprocessing and customization to align with specific business needs. In order to create a more effective chatbot, one must first compile realistic, task-oriented dialog data to effectively train the chatbot. Without this data, the chatbot will fail to quickly solve user inquiries or answer user questions without the need for human intervention. By conducting conversation flow testing and intent accuracy testing, you can ensure that your chatbot not only understands user intents but also maintains meaningful conversations. These tests help identify areas for improvement and fine-tune to enhance the overall user experience. This chapter dives into the essential steps of collecting and preparing custom datasets for chatbot training.

Many businesses choose to create custom datasets by collecting and curating real customer interactions and queries from their e-commerce platforms. Custom datasets allow for more precise training and can be tailored to address unique customer needs. This level of nuanced chatbot training ensures that interactions with the AI chatbot are not only efficient but also genuinely engaging and supportive, fostering a positive user experience.

But it’s the data you “feed” your chatbot that will make or break your virtual customer-facing representation. New off-the-shelf datasets are being collected across all data Chat PG types i.e. text, audio, image, & video. A set of Quora questions to determine whether pairs of question texts actually correspond to semantically equivalent queries.

Break is a set of data for understanding issues, aimed at training models to reason about complex issues. It consists of 83,978 natural language questions, annotated with a new meaning representation, the Question Decomposition Meaning Representation (QDMR). Each example includes the natural question and its QDMR representation.